O Processamento de Linguagem Natural (PLN, ou NLP em inglês) é um ramo da inteligência artificial que se concentra na interação entre computadores e humanos por meio da linguagem. O objetivo central do PLN é permitir que as máquinas entendam, interpretem e respondam à linguagem humana de maneira significativa e útil. Nos últimos anos, o avanço do PLN foi exponencial, impulsionado por novos métodos, algoritmos e principalmente por modelos baseados em redes neurais profundas, como o GPT (Generative Pre-trained Transformer).

Neste artigo, vamos explorar a evolução do PLN, seus principais casos de uso, como a análise de sentimentos, e também entender os detalhes técnicos e os impactos de modelos de linguagem avançados como o GPT.

O que é Processamento de Linguagem Natural?

O Processamento de Linguagem Natural é um campo multidisciplinar que combina linguística, ciência da computação e inteligência artificial. O PLN lida com várias tarefas relacionadas ao entendimento e à geração de linguagem humana. Isso inclui desde tarefas simples, como correção ortográfica e análise gramatical, até tarefas complexas, como tradução automática, resumo de textos e diálogos inteligentes.

Ao longo dos anos, os métodos utilizados no PLN evoluíram de abordagens baseadas em regras, onde linguistas e programadores criavam algoritmos baseados em regras fixas, para métodos baseados em aprendizado de máquina, onde as máquinas aprendem padrões diretamente a partir de grandes volumes de dados textuais.

Principais Tarefas do PLN

Existem diversas tarefas no campo do PLN, cada uma com desafios e características específicas. Algumas das mais comuns incluem:

- Análise de Sentimentos: Determina o sentimento por trás de uma frase ou texto, classificando-o como positivo, negativo ou neutro. Esse tipo de análise é amplamente utilizado em avaliações de produtos, redes sociais e feedbacks de clientes.

- Reconhecimento de Entidades Nomeadas (NER): Identifica entidades específicas em um texto, como nomes de pessoas, empresas, datas e locais.

- Tradução Automática: Converte automaticamente um texto de um idioma para outro, como o Google Tradutor.

- Classificação de Texto: Classifica um texto em categorias predefinidas, como classificar e-mails como spam ou não spam.

- Geração de Texto: Gera textos automaticamente com base em entradas fornecidas, como artigos, descrições de produtos ou respostas em diálogos.

- Summarização: Resume textos longos, mantendo as informações mais importantes.

- Tokenização: Divide um texto em partes menores, como palavras ou frases, para facilitar o processamento.

Cada uma dessas tarefas apresenta desafios distintos, que exigem diferentes abordagens e algoritmos para serem resolvidos.

Abordagens Clássicas para o PLN

Antes da explosão dos modelos de aprendizado profundo, o PLN era dominado por abordagens clássicas de aprendizado de máquina e linguística computacional. Alguns dos métodos mais utilizados eram baseados em:

- Modelos Baseados em Regras: Algoritmos escritos com regras fixas, muitas vezes criados por linguistas, que mapeavam padrões na linguagem. Esses modelos tinham limitações em sua escalabilidade e flexibilidade.

- Modelos Estocásticos e de Cadeias de Markov: Usados para modelar a probabilidade de uma sequência de palavras, auxiliando em tarefas como previsão de palavras e desambiguação.

- Vetores de Palavras: Representações numéricas de palavras (vetores), onde palavras semelhantes em significado estavam mais próximas no espaço vetorial. Modelos como o Word2Vec e GloVe tornaram-se populares, permitindo que algoritmos captassem relações semânticas entre palavras.

Essas abordagens tradicionais eram limitadas em sua capacidade de entender o contexto e as nuances da linguagem humana. A introdução de redes neurais profundas e modelos de aprendizado por transformadores trouxe uma revolução para o PLN, permitindo que as máquinas compreendessem melhor a linguagem.

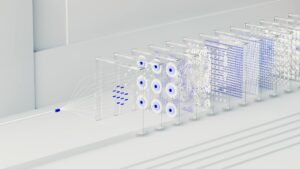

Redes Neurais e o Avanço dos Modelos de Transformadores

Os grandes avanços no PLN começaram com a aplicação de redes neurais recorrentes (RNNs) e, posteriormente, com a introdução de redes de longo curto-prazo (LSTM), que melhoraram a capacidade dos modelos em manter informações de contexto em sequências longas de texto. No entanto, foi a introdução dos modelos de Transformers que trouxe uma verdadeira revolução.

O que são Transformadores?

O modelo de Transformer, introduzido por Vaswani et al. no artigo “Attention is All You Need” em 2017, trouxe uma maneira inteiramente nova de processar linguagem. Ao contrário das redes neurais recorrentes, que processam sequências de forma sequencial, os Transformadores processam o texto em paralelo, usando mecanismos de atenção. Esses mecanismos permitem que o modelo preste atenção a todas as partes do texto de uma só vez, em vez de apenas olhar para palavras adjacentes.

O mecanismo de atenção é a chave para o sucesso dos Transformers. Ele permite que o modelo atribua pesos diferentes a diferentes palavras no texto, com base em sua relevância para a tarefa em questão. Por exemplo, ao processar uma sentença como “O gato está no tapete, e ele está dormindo”, o modelo pode entender que “ele” se refere ao “gato”, mesmo que essas palavras estejam distantes no texto.

GPT e Modelos de Linguagem Baseados em Transformadores

O GPT (Generative Pre-trained Transformer), desenvolvido pela OpenAI, é um exemplo marcante de um modelo baseado em Transformers. A primeira versão do GPT foi lançada em 2018 e rapidamente evoluiu, com o GPT-2 e o GPT-3 alcançando resultados impressionantes em uma variedade de tarefas de PLN. O GPT-3, em particular, contém impressionantes 175 bilhões de parâmetros, tornando-o um dos maiores modelos de linguagem já criados.

O GPT segue uma abordagem de pré-treinamento e ajuste fino. Ele é pré-treinado em uma enorme quantidade de dados textuais de várias fontes, como livros, artigos e sites, e aprende a prever a próxima palavra em uma sequência. Esse pré-treinamento gera um modelo de linguagem geral que pode ser ajustado posteriormente para tarefas específicas, como responder perguntas, gerar textos ou até mesmo manter diálogos.

Funcionalidade do GPT

O GPT utiliza um modelo de linguagem baseado em auto-regressão, o que significa que, para cada palavra ou token gerado, ele usa o contexto anterior para prever a próxima palavra. Isso permite que o GPT seja altamente eficaz na geração de texto coerente e fluente.

Os resultados alcançados pelo GPT são impressionantes. Ele pode ser usado para:

- Geração de Textos: GPT pode gerar textos longos e coerentes com base em um prompt inicial, o que o torna útil para redação de artigos, criação de histórias, resumos e muito mais.

- Chatbots: Ele pode manter conversas com humanos, responder perguntas e até fornecer assistência em atendimento ao cliente.

- Tradução e Adaptação: O modelo pode ser usado para tradução automática, adaptando-se a diferentes idiomas e estilos de escrita.

- Resposta a Perguntas: O GPT pode responder perguntas baseadas em conhecimento contextualizado que foi aprendido durante o treinamento.

Desafios e Considerações Éticas

Embora os modelos como o GPT tenham transformado o campo do PLN, eles também levantam desafios importantes, principalmente em relação a viés, alucinações e responsabilidade ética. Como os modelos são treinados em grandes quantidades de dados da web, que incluem preconceitos e informações errôneas, eles podem reproduzir ou amplificar vieses presentes nos dados.

Além disso, modelos como o GPT podem gerar respostas incorretas ou enganosas com confiança, o que levanta preocupações sobre sua utilização em áreas sensíveis, como saúde ou direito. Portanto, é fundamental que os desenvolvedores de PLN implementem medidas para mitigar esses problemas e garantir o uso responsável da tecnologia.

Análise de Sentimentos e Casos de Uso Reais

Uma das aplicações mais populares do PLN é a análise de sentimentos. A análise de sentimentos envolve a classificação de textos com base em suas emoções subjacentes, como positivo, negativo ou neutro. Essa técnica é amplamente utilizada em:

- Mídias Sociais: Empresas analisam comentários e menções de seus produtos nas redes sociais para entender a percepção do público.

- Feedback de Clientes: Analisar automaticamente as avaliações de produtos e serviços para identificar áreas de melhoria.

- Política: Monitorar o sentimento em relação a candidatos e políticas durante campanhas eleitorais.

A análise de sentimentos, embora poderosa, também enfrenta desafios. A ironia, o sarcasmo e as ambiguidades da linguagem humana podem confundir os modelos. No entanto, com o avanço dos modelos baseados em Transformers, como o BERT (Bidirectional Encoder Representations from Transformers), os sistemas estão cada vez melhores em capturar nuances e contextos complexos da linguagem.

Futuro do Processamento de Linguagem Natural

O futuro do PLN parece brilhante. Modelos como o GPT continuam a evoluir, com novas versões sendo desenvolvidas para serem mais eficientes e éticas. Pesquisas em multimodalidade, que combinam texto com outros tipos de dados como imagens e vídeos, também estão avançando, tornando possível que sistemas de IA interpretem e gerem conteúdo mais rico e diversificado.

Além disso, o desenvolvimento de modelos mais eficientes, que exigem menos poder de processamento e são mais acessíveis, democratizará ainda mais o PLN, permitindo que empresas de todos os tamanhos e desenvolvedores independentes aproveitem seu poder para criar soluções inovadoras.

Conclusão

O Processamento de Linguagem Natural evoluiu enormemente desde seus primórdios, passando de simples algoritmos baseados em regras para sofisticados modelos de redes neurais que podem gerar texto com fluência humana. Desde a análise de sentimentos até a geração de texto, o PLN está moldando a maneira como interagimos com a tecnologia e revolucionando setores inteiros.

Modelos como o GPT representam um marco no progresso do PLN, oferecendo uma visão de um futuro onde a comunicação entre humanos e máquinas será ainda mais integrada e natural. No entanto, com esse poder vêm responsabilidades, e é essencial garantir que essas tecnologias sejam desenvolvidas e usadas de maneira ética e inclusiva.

Seja o primeiro a comentar